今回は、ヒューマン・コンピュータ・インタラクション (HCI) を研究しているYahoo! JAPAN研究所の池松に、研究内容や研究の進め方、研究者として大切にしていることなどを聞きました。

- 目次:

- HCI(Human-Computer Interaction)とは?

- 課題解決型と新規提案型で進めるHCIの研究内容

- 実験や研究の進め方も、コロナ禍に適応してきた

- これまでできなかったことをできるように HCIの研究者として大切にしていること

2019年お茶の水女子大学大学院人間文化創成科学研究科 博士課程修了。博士 (理学) 。2019年ヤフー株式会社 Yahoo! JAPAN研究所 特任研究員。主任研究員を経て、2021年より上席研究員。

2020年より東北大学電気通信研究所にて助教を兼任。ヒューマン・コンピューター・インタラクション (HCI) を専門とし、主にスマートデバイスにおける入出力インターフェースを研究している。

ヤフーのサービスに研究内容をどのように生かしていきたいか

サービス担当者と一緒にサービス改善を進めるときは、そのサービスが持っているデータを分析したり、私たちがクラウドソーシングを利用して数100人から数1000人規模でユーザー実験を実施したりして、実施内容の定量的な効果を示しつつサービスの改善方法を議論していきたいと考えています。

HCIの研究を長期的にはヤフーのサービスに導入することも目指しています。ただ、すでにあるサービスに新規機能として導入するのはとても難しいことだとも思っているので、今はまず研究内容を論文として世に出して、外部からしっかり評価されることに注力しています。

私はスマホなどで用いることのできる新しい操作方法の提案について研究しているので、いつかヤフーの全てのサービスに共通する操作方法を検討してみたいですね。

HCI(Human-Computer Interaction)とは?

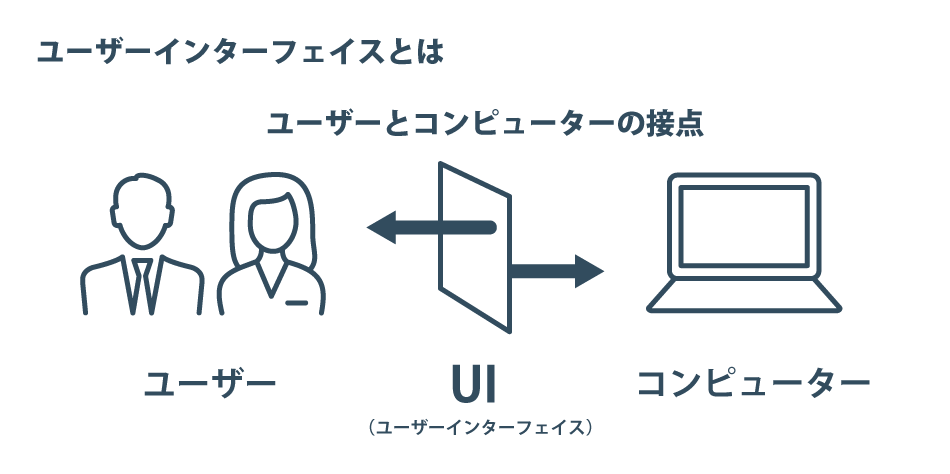

HCIとは、ヒューマン・コンピューター・インタラクション(Human-Computer Interaction)の略です。直訳すると「人とコンピューターの相互作用」という意味です。

もう少しかみ砕くと、人がコンピューターをより快適に、便利に利用するためにはどのような方法が望ましいかを研究するものです。人とコンピューターの間をつなぐユーザーインターフェースに着目して研究し、情報交換の方法を設計することに取り組んでいます。

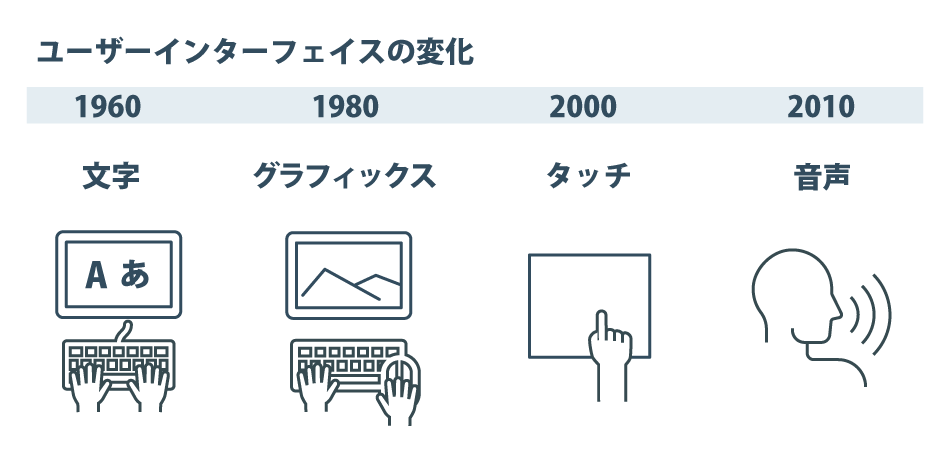

ユーザーインターフェースはこれまで、大きく進化してきました。初期のコンピューターではCharacter User Interface(CUI)という、キーボードでコマンドを打ち込んで入力するものが採用されていました。その後、図形などグラフィカルな情報をマウスでクリックして操作するという、Graphical User Interface(GUI)になりました。

さらに、スマートフォンが普及して以降はTouch User Interfaceが主流になり、最近ではAlexaやSiriのような、Voice User Interfaceも一般的になりつつあります。

私の研究は、このようなユーザーインターフェースについて、人がコンピューターをどのように利用しているのかを観察し分析して、その人たちが直面している困難を解決する方法を模索し、新しい技術を導入することで解決することを目的としています。

ユーザーインターフェースの変化

・Character User Interface(CUI):キーボードでコマンドを入力

・Graphical User Interface(GUI):図形やグラフィックをマウスでクリック

・Touch User Interface:スマホとともに一般に普及。指でタッチ

・Voice User Interface:音声で操作

課題解決型と新規提案型で進めるHCIの研究内容

HCIは学際的な研究分野のため、研究を進める際の方法は多様ですが、私は大きく分けて2つの進め方で研究を行っています。

課題解決型

まず1つ目は、ユーザーがコンピューターを操作しているときの挙動などを観察し、何か問題が発生しているのか、何が問題なのかを調べる方法です。その問題を解決するために既存の方法ではどういうものがあり、何をカバーできていないのかを研究していく、課題解決型です。

新規提案型

HCIの研究分野は、今あるものを少しずつ改良していくことも重要な研究ですが、まったく新しい使い方を考える、これまでできなかったことをできるようにすることも、とても重要なテーマです。

たとえばスマホを使うときには、今は指でタッチするのが主要な操作方法ですが、「スマホ周辺の空間で何か入力のためのジェスチャー操作を識別しようとしたら、どのセンサーを使ったらいいか」など、新しい使い方をいろいろ考えていく、新規提案型がもう1つの進め方となっています。

これまで、主にスマホやタブレットのTouch User Interfaceの研究に取り組んできました。そのなかから、いくつかの内容についてご紹介します。

1)スマホをどのように持っているか推定し、自動的に画面の表示設計を変える

スマートフォンなどの端末は、基本的に指先でのタッチやスクロール、ピンチ(※)などの操作を前提に設計されています。このような直接操作は、「表示されているものを指で操作する」ので感覚的にやはりわかりやすいと思います。操作性も高いのですが、それでも「どうしても片手でしかスマホの操作ができない」など、使いにくくなってしまう状況やタスクも発生します。

※ピンチ:

pinch=摘む。ピンチアウト:二本の指を広げて画面を拡大

ピンチイン:離れた二本の指を近づけて画面を縮小

ここでご紹介するのは、今年の5月にCHI (ACM CHI Conference on Human Factors in Computing Systems)というカンファレンスで発表した、慶應義塾大学と東京工科大学との共同研究です。

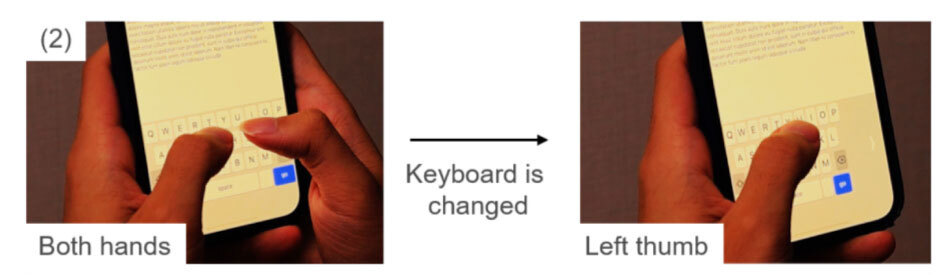

たとえば、両手でスマートフォンを持っているときは、ボタンなどのインタラクティブな要素が画面上のどこにあっても簡単にタップできるかと思います。ですが、片手で操作しているときには画面の端の方は操作しにくくなります。

そのような問題を解決するため、「その人がどのようにスマホを持っているかを推定」して、自動的に画面の表示を変えるという研究です。

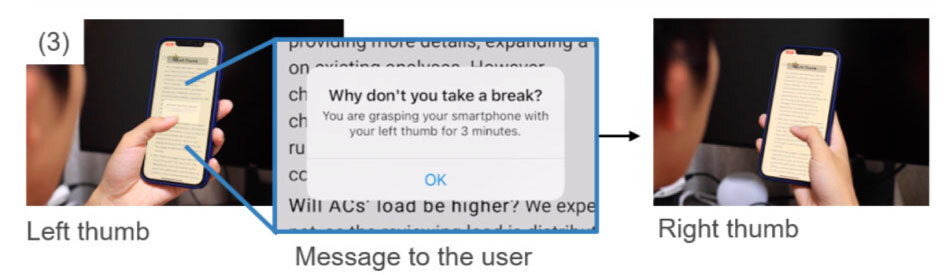

この画面では、ユーザーが両手持ちから片手(左手)持ちに切り替わったということを識別して、ボタンの表示位置を画面下部から、片手でも簡単にタップできる左端に変えています。

どのようにスマホを持っているかを識別し、ボタンの位置を変えている

また、キーボードも両手操作から片手での操作に切り替わったら、端の方のキーはタップしにくくなります。そのため、この例では持っている手の方に寄せて表示しています。

キーボードの位置が左側に寄っている

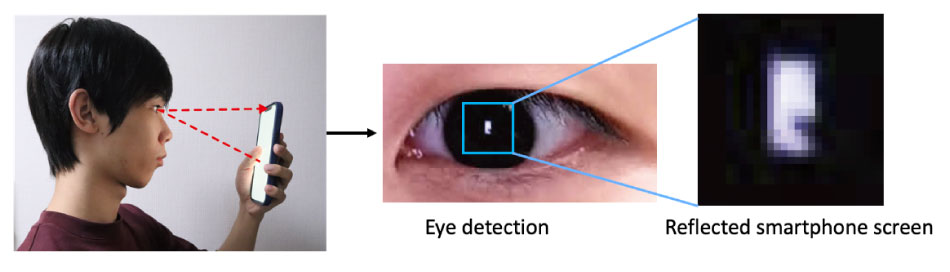

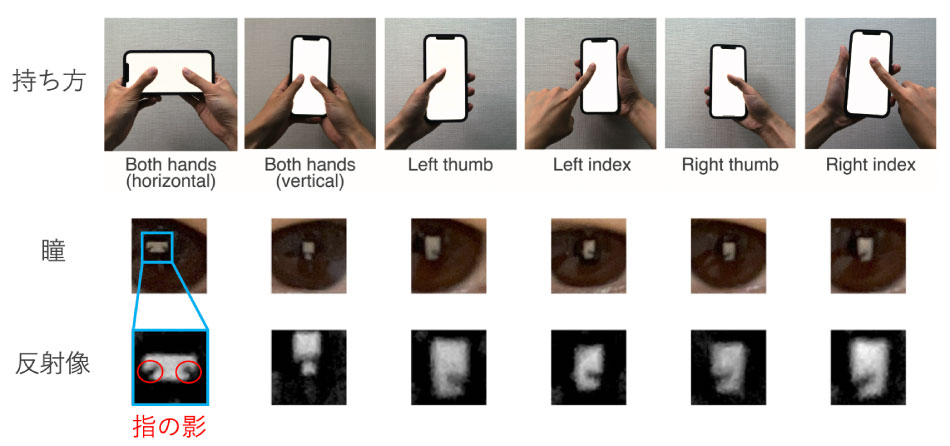

この研究では、スマホを持つ手が片手なのか両手なのか、縦持ちか横持ちか、タップする指が人差し指か親指かを、スマホのフロントカメラ(インカメラ)を使って推定しています。人がスマホを操作しているとき、目の角膜の部分にスマホの画面から発している光が反射して映ります。そうすると、指を載せている部分がこのような影の形になります。

これは反転して写っている画像のため、左手で持っている状態だということがわかります。これらの角膜反射像を使って識別、推定した結果をもとに、今の持ち方に最適なユーザーインターフェースを提供できるようになるのではないかと考えました。

この研究を思いついたのは、東大・矢谷浩司先生の研究室の「コンピューター使用時に目の乾燥状態を検出する手法」についての論文を読んだことがきっかけです。

モニターディスプレーに格子状の白黒の画像を表示して瞳に投影させ、その瞳の情報をカメラで読み取った画像がゆがんでいると、ドライアイの可能性が高いと推定できるという研究でした。それを読んで、角膜にそんなに鮮明に画像が映るものなのだろうかと思って、家族がスマホをいじっているときの角膜をじっと観察してみました。

そのときに、「確かに意外とはっきり画面が映るし、おおよその手の動きも分かる」と思い、「スマホをどのように持っているか、持っている手の輪郭くらいだったら角膜に映った像をスマホのフロントカメラで読み取れるかもしれない」と考えたことが、この研究につながりました。

コロナ禍になってから、みなさんスマホを使う時間がとても長くなっていて、腱鞘炎(けんしょうえん)などの外科疾患の報告が増えているそうです。

この研究内容を応用すれば、ずっと同じ指使いで何時間も操作していたという記録も取れます。腱鞘炎は同じ筋肉を使い続けることが原因の一つと言われているので、たとえば一定時間が経過したら「持ち方を変えてみましょう」「机に置きましょう」「少し休みましょう」などのメッセージを出すことで、外科疾患を未然に防ぐことが可能になるかもしれないと考えています。

2)スマホを物理的に拡張する

一般に、スマホは「静電容量方式(※)」というタッチセンシング機構を採用しています。これは、導電性のもの、たとえば金属などを手で持って画面に接触させた場合にも、指でタッチしたときと同じように操作できます。電池が不要なタイプのタッチペンもそれと同じ仕組みです。

※静電容量方式:

指とタッチパネルの間に発生する、静電容量の変化からタッチ位置を検出する方式

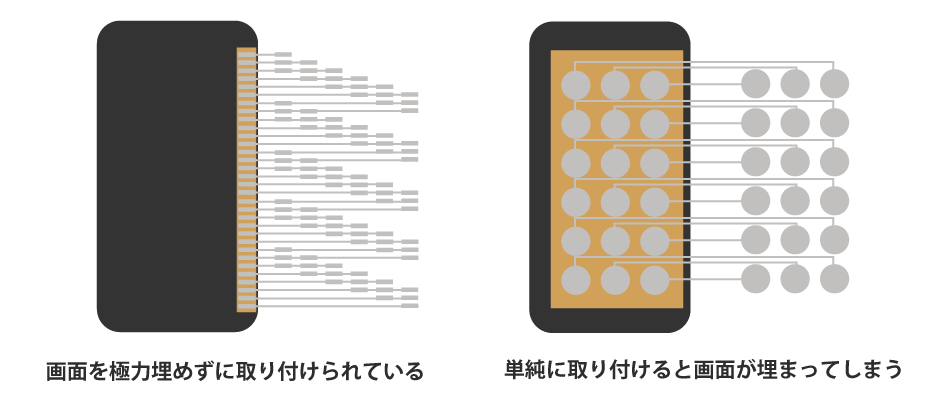

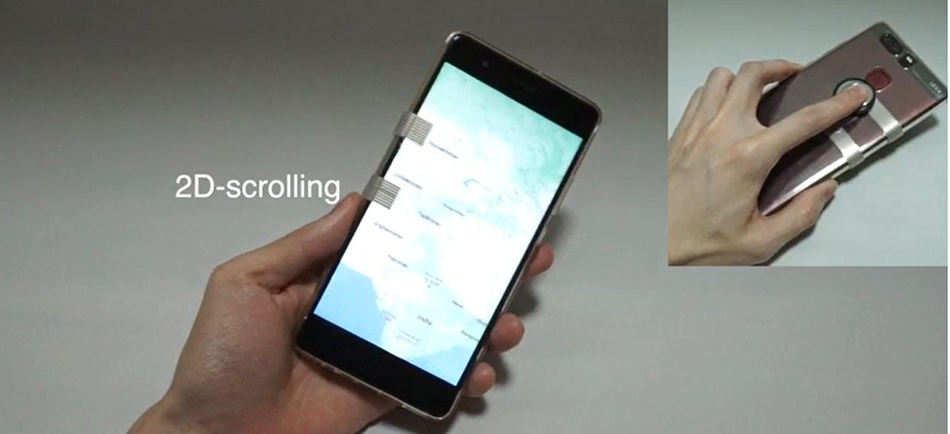

これは、東京工科大学と共同で進めている、スマホ画面の外側にタッチ入力部を拡張する入力インターフェースの研究です。この画面に取り付けられたシートには導電性のインクのパターンが印刷されていて、これに触れることでスマホ画面をタップするのと同様の操作が可能になるというものです。電池も充電も不要で、貼り付けるだけで使えます。

画面に取り付けた導電性の物体を通じてタッチができる仕組みを使った研究はこれまでもありました。ただ、指先大ぐらいのサイズのものを取り付けないと反応しにくいため、入力部を多数提供しようとすると画面全体が埋まってしまいます。これに対し、私たちは画面を埋める面積を極力狭くしつつ、多数の入力部を提供できるインターフェースを作成しました。入力部に触れると一部の導電パターンと指が接続され、入力部ごとに指と接続されるパターンが少しずつずれるようになっているので、画面上のタッチ検出位置が変化します。そのタッチ座標から、ユーザーがどの入力部に触れたのかを判定しています。

このように拡張しタッチ入力できるものがスマホなどの裏側に付いていれば、背面をタッチして操作することも可能になります。

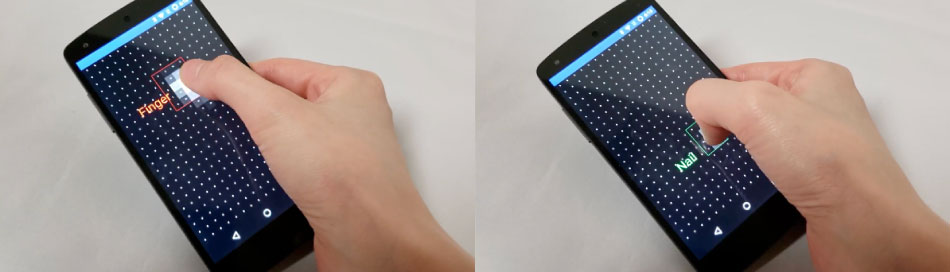

3)爪でのタッチ入力を可能にしてショートカットコマンドを2倍に

爪でのタッチ入力を検出し、指とは別のタッチとして区別することで、爪を当てたときに「爪でタッチするとコピー」「爪でフリックすると別のアクションに割り当てる」などを可能にする入力手法の研究です。こちらも静電容量方式のタッチセンシングのデータを利用して判別しています。

スマホのタッチ操作自体はわかりやすいのですが、ショートカットコマンドがキーボードに比べるとかなり少ないですよね。限られた入力面で、さらに多くのコマンドを提供できたら、スマホをよく使う人にとって便利な機能になるのではないかと考えました。

たとえば爪でダブルタップ、爪でスワイプするなど、これまで指でやっていた操作を単純に2倍にできるため、よりPCやスマホを便利に使えるようになるのではないかと思っています。

HCIの研究で進めているもの

1)スマホをどのように持っているか推定し、自動的に画面の表示設計を変える

2)スマホを物理的に拡張する

3)爪でのタッチ入力を可能にしてショートカットコマンドを2倍に

実験や研究の進め方も、コロナ禍に適応してきた

ここで紹介したような入力手法の研究では、まず実験用のアプリを作り、それをもとに予備的な調査をすることで、その研究の初期的な妥当性を確かめます。その上で実際にユーザーに使ってもらい、ユーザビリティがどのくらい上がったかなどの効果を検証します。その結果を他に何に使えるかもあわせて検討し、応用例を数パターン用意するまで進められてはじめて1つの論文を完成させることができます。

HCI分野のトップカンファレンス(論文採択率は約25%前後)やジャーナルはそれなりに投稿先があるので、3カ月に1回ぐらい、何かしらの論文の締め切りがあるペースです。ハードウエア的な作業で工作器具を使うことも多いのですが、自宅に3Dプリンターなどもあるので、自宅で研究を進める日が多いですね。

HCI系の分野は対面で実験を行うことが多いのですが、コロナ禍をきっかけに、実験方法もクラウドソーシングを用いるものが徐々に増えてきました。

操作している様子を目の前で見られるわけではないため、指示した操作を適切に行っていない「ノイズ」データも含まれる可能性はありますが、クラウドソーシングであれば100人、1,000人という多くの方に協力いただけるので、データの適切な処理を行えば大きな問題はなく進められます。また、予備調査として数名にZoom越しに実験時の様子を撮影してもらって確認することもしています。

コロナ禍で生まれた制約をいかに排除しながら研究を進めるかということに、今まさに取り組んでいるところです。

これまでできなかったことをできるように HCIの研究者として大切にしていること

HCI研究では、既存のものを改善するだけではなく、これまでできなかったことをできるようにすることがとても大事なテーマだと思っています。そのテーマに貢献できるような新しいアイデアを常に考え続けることを大切にしています。

ただ、HCI分野の研究は他の学問領域とは比較にならないほど分野横断的かつ学際的な領域で、私が研究対象としている内容はそのうちごくわずかな範囲です。

たとえばHCI分野のトップカンファレンスのCHIで発表される研究は、認知心理学やデザイン、アートの分野や技術開発、ディープラーニングを使うようなものまで、本当に幅広い範囲をカバーしています。それらが人とコンピューターの境界であるユーザーインターフェースに着目しているというところは共通しています。

そして、ユーザーインターフェースの変遷もまた起きると予想されるので、この分野はおそらく、人生を懸けてもきっとやりきれないぐらい広い領域だと感じています。

たとえば近い将来、メタバース(※4)のようなものがこれまで以上に身近なものになってくるのではないでしょうか。

ただ、HMD(ヘッドマウントディスプレー)をかぶってコントローラーを持つような世界のなかで、文字を入力する、コミュニケーションを取るなどの基本的な機能はどのようなものが良いかの指針は、まだそこまで明確にはなっていない状態だと思っています。それらを1つ1つ検証していくことも研究になり得ます。

これから先、また技術的なブレークスルーが起こったときに、どういうユーザーインターフェースが適切なのかは、誰にもわかりません。これからも、何かブレークスルーが起こるたびにHCIの研究テーマが出てきて、それに対して取り組み続けていくのだと思います。

※4 メタバース:

コンピューターネットワークの中に構築され、3次元の仮想空間やサービス

【関連リンク】

- Xiang Zhang, Kaori Ikematsu, Kunihiro Kato, Yuta Sugiura. ReflecTouch: Detecting Grasp Posture of Smartphone Using Corneal Reflection Images. In Proc. of CHI ’22.

- Kaori Ikematsu, Kunihiro Kato, Rei Kawakami. ShiftTouch: Sheet-type Interface Extending Capacitive Touch Inputs with Minimal Screen Occlusion. UIST '21 Adjunct.

- Kaori Ikematsu, Shota Yamanaka. ScraTouch: Extending Interaction Technique Using Fingernail on Unmodified Capacitive Touch Surfaces. PACM on IMWUT, Vol. 4, No. 3, Article No. 81 (2020)